Cervell: Ciències cognitives i Xarxes neuronals. Intel·ligència, evolució AI

AI simbòlica Xarxes neuronals i Connexionisme Aprenentatge automàtic (Deep learning)

AI generativa: Evolució Eines i desenvolupament LLM models de llenguatge Media Xatbots (acompanyament)

Impacte AI en la ficció Discussió Un museu de la AI

AI simbòlica

- 1950: Test de Turing: una màquina es podria considerar intel·ligent si era capaç d’enganyar un ésser humà fent-li creure que estava parlant amb una altra persona en lloc d’una màquina. No valorava la comprensió real ni la consciència, sinó la capacitat de simular intel·ligència.

- ELIZA. El 1964 Joseph Weizenbaum escriu un programa en MAD-SLIP for CTSS en un IBM 7094, que simula un terapeuta PCT (Person Center Therapy,) Bàsicament pregunta l’usuari com se sent i retorna les seves frases. L’autor va quedar sorprès quan els usuaris, incloent la seva secretària, atribuïen comprensió i sentiments al programa. Una simulació.

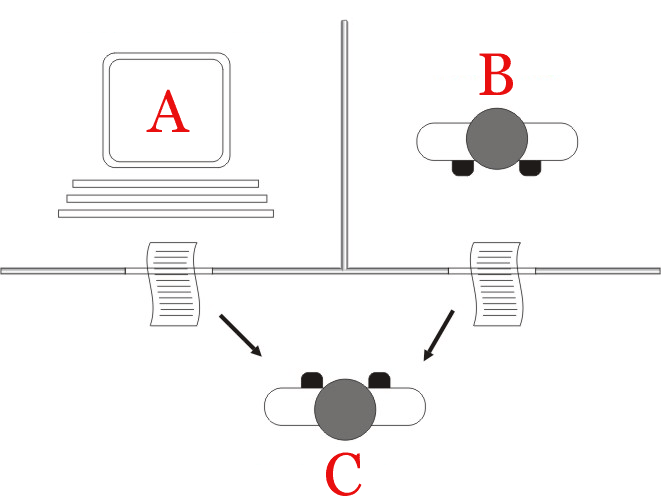

Entrada d’text (input): L’usuari introdueix una frase en llenguatge natural. ELIZA llegeix el text i l’analitza paraula per paraula.

Base de dades de patrons i respostes: es detecten patrons de paraules clau com “estic trist”, “la meva mare”. Hi ha preparades respostes associades com “Per què creus que ets trist?”, “Digués més sobre la teva mare”. Tranformació de “jo” a “tu” en la resposta: “Tinc problemes amb el meu germà.” -> “Com afecten els teus problemes amb el teu germà?”, (patró: “problemes amb [família]” + transformació). “Sóc solitari” → “Per què ets solitari?”.

Si el text coincideix amb un patró coincideix amb un patró s’aplica la plantilla. Sinó es recorre a frases com “Continua”, “Com et fa sentir això?”, “Explica’m més sobre això”).

- 1950-1980: Intel·ligència Artificial Simbòlica (dècades 1950-1980). Manipulació de símbols i aplicació de regles lògiques per resoldre problemes complexos, com jugar als escacs o demostrar teoremes matemàtics.(llenguatges LISP i prolog). Aquest enfocament de la intel·ligència com a conjunt de regles tenia dificultats per gestionar la incertesa, l’aprenentatge i les tasques que requereixen sentit comú.

- Teoria de la informació i cognitivisme de Newell, Shaw i Simon (1956). Model de processament de la informació (inspirat en ordinadors). El seu logic theorist va provar 38 dels primers 56 teoremes dels Principia Mathematica de Russell. De manera general les persones solucionarien problemes segons un model (General problem Solver, GPS). Problem space: conjunt de tots els estats possibles en què pot trobar-se el sistema (en particular l’estat inicial i l’estat objectiu) i els operadors que transformen un estat en un altre (per exemple, moure una peça sumar un número, aplicar una regla lògica [no deixa de ser un IF…THEN])… Hi hauria estratègies heurístiques per trobar la solució o almenys reduir el nombre d’opcions a considerar. El GPS avalua la distància entre l’estat inicial i l’objectiu i compara quines operacions redueixen aquesta distància (means-ens analysis). Va suposar la inauguració de la AI simbòlica. Es podia aplicar en problemes ben definits (com puzzles, proves de lògica…) però no funcionava bé amb problemes oberts o amb incertesa. El model va ser millorat pel ACT-R de John Anderson que identifica els diferents mòduls que intervenen memòria declarativa, visual, motor, amb intervenció de porocessos subsimbòlics en la recuperació de records. Als anys 80-90 la AI >>va començar a explorar la via subsimbòlica.

- LISP. Desenvolupat el 1960 per John Maccarthy i implementat per Steve Russell en un IBM; 704. Processa llistes escrites com, (1 2 4 pepito (zona pepa)). Els operadors es posen al començament de la llista (if condicio consequencia), o (+ 1 2 3 (* 4 5)). Per provar: TIO. Exemple:

(defun pare (x y)

(or (and (eq x ‘joan) (eq y ‘maria))

(and (eq x ‘joan) (eq y ‘pere))))

(defun germans (x y)

(and (pare ‘joan x)

(pare ‘joan y)

(not (eq x y))))

Crida: (germans ‘maria ‘pere)

Resposta: T (true)

- PROLOG

Desenvolupat per Alain Colmerauer entre 1972 i 1995. És un llenguatge de programació declarativa i lògica. Tu declares fets i regles, i el sistema respon a consultes (queries) mitjançant resolució lògica i unificació. El flux d’execució es basa en cercar solucions que satisfacin les condicions donades. Ha estat important en el món acadèmic però de poc impacte en la indústria en general.

Els seus termes poden ser àtoms ‘jordi’, ‘P(jordi)’, números, variables, llistes [Jordi, 2], strings “avui és dilluns”. Amb els termes es poden definir fets human(Jordi), o regles, mortal(X):- humà(X). Si preguntem qui és mortal ?-mortal(X) ens dirà X=Jordi. S?ha fet servir per intentar demostrar teoremes i per construir ontologies OWL . (Semàntica). Per provar: SWISH, Learn prolog. TIO

Exemple:

pare(joan, maria).

pare(joan, pere).

germans(X, Y) :- pare(Z, X), pare(Z, Y), X \= Y.

Consulta: ?- germans(maria, pere).

Resposta: true.

- Sistemes experts: Es va fer servir per construir sistemes experts com DENDRAL per identificar mol·lècules orgàniques i MYCIN per diagnosi mèdica. Feien servir backward chaining. A partir d’una base de dades de fets i les seves conseqüències, parteix del resultat final per mirar de trobar quins fets han conduit cap a aquest resultat. Per exemple: IF febre AND leucocits alts → Infecció bacteriana amb probabilitat 0.7. Avui la majoria fan servir LLMs però Symptomate recull el plantejament de MYCIN original (reproduïble en rubi). (Ada per iphones). Isabel.

Estratègia i jocs

ESCACS: es construeix un arbre amb les jugades possibles i s’assigna un valor numèric que avalua cada posició, assignant un valor a les peces, fortalesa del rei, peces amenaçades, moviments disponibles (Stockfish).

El 1997 Deep Blue de IBM derrota GAry Kasparov. Estava escrit en C (algorismes d’avaluació de posicions, cerca d’arbres, etc.) i algunes rutines en assembler. Tenia 256 processadors dedicats i arribava a avaluar fins a 200M de posicions per segon.

Alphazero simplement emmagatzema milions de partides i en treu un valor estadístic. Es pot provar amb Lichess. Lucas Chess.

Xarxes neuronals

Computadores de procés en paral·lel

En l’arquitectura de Von Neumann, hi ha una unitat central que rep una instrucció per operar una dada entrant que s’obté de la memòria i donar un resultat. Gauss (1795) i Legendre (1805), havien fet servir el mètode dels mínims quadrats per aproximar un conjunt de punts a una funció (un polinomi, per exemple), i imposant que el quadrat de la diferència entre els punts i els valors sigui mínima.

Orígens de les xarxes neuronals (1940s–1960s)

McCulloch i Pitts (1943): Van proposar el primer model computacional d’una neurona, una versió molt simplificada però fonamental.

El 1944 Hebb va proposar un model d’aprenentatge en que els senyals entre nodes venien ponderats per pesos, i que quan dos nodes adjacents s’activaven, el pes es reforçava: Neurons that fire together, wire together. (la base bioquímica dels pesos de la xarxa, potenciació i inhibició: neurones a tipus de cèl·lula animal). El pensament sorgiria de patrons d’activació neuronal que es consoliden per l’experiència (Hebbian learning). [notem que ja no busquem un model basat en la nostra experiència introspectiva del procés d’entendre i buscar solucions, sinó un model que explica inputs i outputs en una xarxa. (1949, The organization of Behavior)

El Perceptron i l’hivern de la AI

El 1958 Frank Rosenblatt construeix el perceptron que va crear moltes expectatives per aconseguir màquines que “pensessin”. Era un model d’aprenentatge supervisat en el sentit que els pesos es reajustaven més o menys segons la diferència entre el resultat obtingut i l’esperat. El model que va construir tenia una entrada de 20×20 connectat amb pesos ajustables a una sola neurona. Un cop entrenada podia reconèixer un dígit. Demo

Però el 1969 Minsky and Papert van descobrir les limitacions dels Perceptrons per incorporar la disjunció exclusiva XOR [o l’un o l’altre, per exemple si arròs és bo, i llet és bona, no el podrem entrenar per que identifiqui és bo si arròs o -exclusiu- llet] i la recerca es va frenar. (AI Winter). Durant unes dècades la AI va treballar sobretot manipulant cadenes de símbols i aplicant lògica de manera seqüencial amb programes com Prolog i Lisp. Funcionaven bé en tasques com validar teoremes o recórrer arbres de diagnòstic però eren incapaços de reconèixer formes imperfectes. GOFAI (Good Old-Fashioned AI).

xarxa d’una capa amb diverses neurones

Connexionisme

Representacions distribuïdes i esquemes

[Treball 1993] El 1986 es va publicar Parallel Distributed Processing per Rummelhart i Mclelland (text) que estudiava un model similar al del cervell. Les representacions no estarien emmagatzemades en forma de regles sinó distribuïdes en els pesos de les connexions dels nodes de la xarxa. Així, un input imperfecte activa una sèrie de nodes que identifiquen un patró.

Sembla clar que a una escala de segons i minuts, el procés cognitiu humà és seqüencial. S’examina un problema, es consideren diferents dades relacionades, s’infereix una solució, s’avaluen les expectatives, etc… Ara bé, cada un d’aquests passos, com per exemple, reconèixer una figura, identificar una situació o recuperar una informació de la memòria, es podria descompondre en una gran quantitat de processos petits. La hipòtesi del PDP és que els microprocessos que constitueixen cada un dels passos seqüencials, són de naturalesa distribuïda i no seqüencial. McClelland i Rummelhart parlen de la microestructura del coneixement, en el mateix sentit que les partícules subatòmiques constitueixen i expliquen els àtoms com a compostos superiors: “en general, des del punt de vista de PDP, els objectes als quals es refereixen els models macroestructurals del procés cognitiu, es poden veure com a descripcions aproximades de les propietats emergents de la microestructura.

L’estat d’activació d’un node és funció dels estats d’activació dels nodes amb qui està connectat ponderat per diferents pesos. S’exploren diferents processos d’actualització dels pesos de la xarxa [que vindria a ser com un aprenentatge perceptiu]. Es pot ajustar per tal que la sortida correspongui a un output esperat, aprenentatge supervisat per exemples. Un d’ells consisteix a propagar enrere la diferència observada a la sortida (backpropagation error), així veiem quins nodes són responsables d’acumular l’error i baixem el pes. O bé es poden anar repetint inputs similars fins que es reforcin certes connexions (aprenentatge no supervisat [així s’associarien per exemple, la imatge d’un gos amb com borda].

Encara no es coneixen els mecanismes d’emmagatzematge d’informació. No podem dir “al concepte X o a la imatge de Y li correspon tal configuració de neurones”. A grans trets sí que s’han identificat les àrees del cervell que reben les dades sensibles i que al lòbul frontal hi ha l’àrea associativa lliure. En els estudis sobre memòria s’observa una memòria sensorial (<1s), una memòria primària (verbal, de l’ordre de segons), una memòria secundària (minuts, anys), i una memòria terciària (permanent). El model PDP proposa que les percepcions consisteixen en patrons d’activació estables. Després d’un procés d’aprenentatge, l’activació d’un dels nodes [exemple imatge d’un gos, ni que sigui parcial], activa la resta de nodes que acostumen a anar junts [regla de Hebb]. La informació està en els pesos de les connexions entre nodes (neurones) wij. Hi ha models per percepcions i per procés lingüístic, relacions tot-parts, i abstraccions. Recuperar informació no és obtenir un registre mitjançant una clau d’índex sinó que suposa un procés d’inferència: una informació parcial, com la forma o la paraula, activa un patró amb tota la informació. (Senden Percepció: aprenentatge perceptiu). Els patrons estables d’activació que emmagatzemen informació sobre un objecte, un grup d’objectes o una situació, són anomenats esquemes en ciència cognitiva.

[Basant-se en principis biològics i antropològics s’ha dit que tots els éssers vivents converteixen en signes tota experiència, sense necessitat de ser signes pròpiament lingüístics. Una ameba aprofita experiències passades per adaptar-se millor (CERDA, Lingüística d’avui p.64). Això vol dir que la relació de l’organisme amb l’entorn no consisteix només en matèria i energia sinó també en senyals. En els més primitius el senyal serà simplement ‘estic en un medi amb aliment’ o ‘estic en un medi hostil’. En animals més evolucionats hi haurà una concepció de l’espai, del territori, reconeixement del perill per indicis. Això ja suposa una certa representació del món. En l’home aquesta representació arribarà a tenir objectes (categories de quantitat i qualitat) en l’espai i el temps que se succeeixen en seqüències causals. Si li afegim la capacitat biològica d’emetre sons i la convivència tribal, d’aquí podrà néixer el símbol, el concepte i la comunicació.] Aquesta noció ha estat recollida en diferents aspectes al llarg de la història del pensament. A Kant (Brehier II 418) els esquemes eren la regla segons la qual podem construir les imatges corresponents a un concepte. (Ex. l’esquema de la circumferència). I no oblidem que la imaginació era qui determinava l’experiència en termes de les categories de l’enteniment. En Piaget (Richmond p.107) l’esquema seria una unitat de conducta amb estructura. Es parla de l’esquema de succió, de prensió, de desplaçament.

Minsky (1975) parlà de marc (frame), Rumelhart (1975) de schema, i Smolensky muntà la teoria de l’harmonia amb una xarxa que codificava àtoms de coneixement formant una estructura.

Llenguatge: [Als 90, els models de Parallel Distributed Processing de Mclelland i Rummelhart oferien models per entendre com una xarxa pot funcionar com si apliqués regles tot i no tenir-les definides explícitament. L’exemple que es posa és que l’estructura hexagonal d’un rusc resulta de les forces de compressió, però el mecanisme que les executa no conté les regles de simetria amb què es descriu. També presenta un model sobre com conjuguem els verbs. (A PDP18 “On learning de past tenses of english verbs” es presenta un model de xarxa on l’input fonètic de l’arrel del verb és descomposat en un segon nivell de nodes que es connecta a un tercer nivell que correspondrà a la conjugació del passat (p222). Entrenant la xarxa segons l’aprenentatge d’associació de patrons (H1812.1, Perceptron, delta rule) s’aconsegueix, després d’unes 500 passades, que la xarxa generi el passat dels verbs i que presenti la generalització que fan els nens de conjugar de manera regular els verbs irregulars (“s’ha morit” enlloc de “s’ha mort”). Pels cassos en que els pesos de la xarxa proposen vàries opcions cal refinar el model afegint a la sortida un mecanisme de competició.

A PDP 19 “Mechanisms of sentence processing: assigning roles to constituents of sentences” es presenta un model que explica cóm assignem estructura a una frase donada. D’una banda tenim unes frases tipus (“home menja aliment”, “animal es mou” p.290), unes categories d’objectes (home, animal, objecte, eina) als quals es poden assignar diferents valors d’un alfabet (Pere, pau, ratolí, martell) amb unes certes microcaracterístiques (microfeatures). Un cop tenim la frase amb elements de l’alfabet, l’entrenament de la xarxa permet veure que “cadira trenca home” té una estructura c.directe + verb + subjecte (i no S + V + CD). Això vol dir que sap assignar l’estructura correcta fent servir el context semàntic. El model s’hauria de complicar amb d’altres nivells per admetre la ramificació de les estructures bàsiques, és a dir, que un sintagma nominal pot ser N, N+adjectiu, nom+oració subordinada, etc (cf PDP p.318). Per això hem de tenir una xarxa més gran, però també en un llenguatge com el Prolog, quan fem recursió de llistes també necessitem una pila (stack) més gran per anar emmagatzemant totes les determinacions que anem afegint al subjecte abans d’arribar al verb (o en alemany quan en una subordinada llarga ens trobem el verb al final). Encara que una fórmula lògica admet recursió infinita N=a+N i la xarxa no (limitada pel volum), les implementacions concretes també estan limitades, en Prolog pel tamany de la pila i en l’home per la memòria. Podem tractar frases complicades (és a dir amb una ramificació o recursió) fins a un cert límit [límit que, per cert, esgotarien alguns filòsofs com Hegel i els seus paràgrafs].

Parallel Distributed Processing* (McClelland & Rumelhart, 1986)

Foundations – Explorations in the Microstructure of Cognition

Part I: The PDP Perspective

1. The Appeal of Parallel Distributed Processing

2. A General Framework for Parallel Distributed Processing

3. Distributed Representations

4. PDP Models and General Issues in Cognitive Science

Part II: Basic Mechanisms

5. Feature Discovery by Competitive Learning

6. Information Processing in Dynamical Systems: Foundations of Harmony Theory

7. Learning and Relearning in Boltzmann Machines

8. Learning Internal Representations by Error Propagation

Part III: Formal Analyses

9. An Introduction to Linear Algebra in Parallel Distributed Processing

10. The Logic of Activation Functions

11. An Analysis of the Delta Rule and the Learning of Statistical Associations

12. Resource Requirements of Standard and Programmable Nets

13. P3: A Parallel Network Simulating System

Part IV: Psychological Processes

14. Schemata and Sequential Thought Processes in PDP Models

15. Interactive Processes in Speech Perception: The TRACE Model

16. The Programmable Blackboard Model of Reading

17. A Distributed Model of Human Learning and Memory

18. On Learning the Past Tenses of English Verbs

19. Mechanisms of Sentence Processing: Assigning Roles to Constituents

Part V: Biological Mechanisms

20. Certain Aspects of the Anatomy and Physiology of the Cerebral Cortex

21. Open Questions about Computation in Cerebral Cortex

22. Neural and Conceptual Interpretation of PDP Models

23. Biologically Plausible Models of Place Recognition and Goal Location

24. StateDependent Factors Influencing Neural Plasticity: A Partial Account of the Critical Period

25. Amnesia and Distributed Memory

Part VI: Conclusion

26. Reflections on Cognition and Parallel Distributed Processing

Xarxes convolucionals (CNN) i reconeixement d’imatge

Xarxes convolucionals per a reconeixement d’imatge. (CNN). L’entrada és una matriu de 2 dimensions.

1980: el neocognitron de Kunihiko Fukushima és un primer model que s’inspira en la visió biològica. 1989–1998: Yann LeCun desenvolupa LeNet-5, una CNN per reconeixement de dígits (ús a la banca per llegir xecs).

[a partir d’una matriu de píxels la xarxa és capaç de detectar vores. S’aplica un filtre sobre la imatge i es genera una “mapa de característiques” (feature map, s’obtenen per exemple els valors màxims i es comparen amb els mitjans. Els pesos del filtre s’ajusten durant l’entrenament. [la xarxa identifica el mateix patró final encara que hi hagi petits desplaçaments o distorsions, són invariants a translacions petites].

Amb més capes podem fer, per exemple que un primer nivell identifiqui formes bàsiques com un cercle o un oval, després detectar vores i formes a dins, després trobar uns ulls i un nas i finalment, un quart nivell reconèixer un rostre [ho incorporen les apps de fotografia, i Picasa proposar identificar persones].

Xarxes neuronals recurrents (RNN)

Estaven orientades a processar dades seqüencials com text o veu.

[D’alguna manera havien d’explicar com puc tenir alhora informació del passat, com el començament de la frase, o la frase anterior, i informació del moment, com el final de la frase.] Com a antecedents teòrics tenim el model de McCulloch-Pitts (1943) i el Percepton de Rosenblatt. El 1982 Hopfield va proposar un model, recollint idees de mecànica estadística com el model de Ising que explica com s’orienten els spins en un sòlid ferromagnètic. D’altres models van ser el de Jordan (1986) amb connexions recurrents des de la capa de sortida cap a una capa de context i Elman (1990) que afegia una capa oculta recurrent que guardava l’estat anterior, permetent processar seqüències. [quan hi havia bastants passos, en mirar de corregir els pesos tirant enrere, el gradient desapareixia o explotava. Això es va corregir amb els models Long short term memory LSTMs (1997) de Hochreiter i Schmidhuber que es van aplicar amb èxit per al erconeixement de veu. (2006) [per això jo puc dictar al telèfon].

Les xarxes entrenades es van fer servir per processament de llenguatge natural, predint les paraules següents. Més tard es canviaria pel tractament de transformers als LLM. També es van mirar d’aplicar a predicció de sèries temporals com dades financeres o metereològiques.

[Una xarxa CNN entrenada pot identificar objectes a partir de matrius de pixels, gràcies als pesos de la xarxa, projecten inputs molt diversos a un mapa de característiques que correspon a un objecte. Una xarxa RNN entrenada pot predir la paraula que vindrà (un cop tenim els pesos que enllacen diferents mots), o bé projectar un input d’àudio a un mapa de característiques que permetin assignar-lo a uns mots)

Igual que les CNN, fins que no es van fer servir les GPU amb biblioteques com “TensorFlow” o “PyTorch”, no es podien abordar problemes complexos.

[Ciències cognitives

Tota aquesta recerca, AI simbòlica i connexionisme, s’inscriu en un marc més ampli, el de les anomenades “ciències cognitives”. Aquestes pretenien abastar qualsevol “operació o estructura mental que es pugui estudiar amb precisió (Lakoff and Johnson, 1999), i per tant abasten AI, percepció, memòria, llenguatge (sintaxi, Lakoff i Johnson i la metàfora), el paper del cos en la cognició (Varela, The embodied Mind), i consciència.

A més dels experiments de conducta tradicionals, incorporen els resultats de la neurobiologia, simulacions de les operacions de la ment simbòliques i subsimbòliques (el PDP), i discussions de la filosofia de la ment [a la qual vaig dedicar la tesina mirant d’argumentar la limitació del seu plantejament com a manera d’entendre la condició humana: Els exemples en la filosofia de la ment.

Aprenentatge automàtic

La implementació de xarxes neuronals, GPU

En ordinadors d’arquitectura Von Neumann, amb una CPU, són costoses. Al s21 els avenços en hardware ho han fet possible i també s’han construït altres arquitectures: (CGPT) Targetes gràfiques (GPU) que poden treballar en paral·lel. [D’aquí la rellevància de Nvidia]. Tensor Processing Units (TPUs) desenvolupades per Google per a entrenar xarxes. Field-Programmable Gate Arrays (FPGAs). Application-Specific Integrated Circuits (ASICs).

Les xarxes neuronals artificials (ANN) han resultat efectives a l’hora de reconèixer patrons, per exemple en patologia mèdica, identificar patrons en grans conjunts de dades (machine learning) tant en temes de salut com de tendències de consum, reconeixement de veu, predicció de textos. Juntament amb mètodes tradicionals com arbres de decisió, support vector machines (SVMs), k-nearest neighbors (k-NN), i logistic regression, formen part del ràpid desenvolupament de la AI.

[Inicialment les targetes gràfiques estaven pensades per processar matrius de 2 dimensions, però actualment poden treballar amb tensors de fins 8 dimensions. Les dades són convertides a tensors i després tractades eficientment per les GPU]

AlexNet

El 2012 la AlexNet va guanyar el concurs ImageNet Large Scale Visual Recognition Challenge (ILSVRC). Imagenet era una base de dades d’11M d’imatges classificades en 20.000 categories obtingudes a partir del lèxic Wordnet. Va ser creada per Fei-Fei Li. AlexNEt era una CNN profunda desenvolupada per Alex Krizhevsky i * Ilya Sutskever, sota la direcció de Geoffrey Hinton (mentor i figura clau del deep learning). Es va entrenar per classificar 1.2 milions d’imatges en 1000 categories amb un 15% d’error. Tenia una arquitectura de 8 capes d’aprenentatge (5 convolucionals + 3 completament connectades). Es va fer servir una GPU (NVIDIA GTX 580).

Va quedar demostrat que amb suficient potència i suficient volum de dades, la AI podia oferir resultats. Va inspirar arquitectures posteriors molt més sofisticades com VGGNet i GoogLeNet (Inception) (2014) i ResNet (2015).

Tindrem CNNs millorades: VGG, ResNet, Inception… i RNNs / LSTM / GRU: Per processar llenguatge, veu i seqüències.

Machine Learning

L’aprenentatge automàtic es basa essencialment en extreure la informació rellevant d’un gran conjunt de dades aplicant compressió. Per exemple en una imatge de 1MB, només potser 10KB d’informació són útils per saber si hi ha un gos o un gat. La resta és soroll o detall innecessari. Els models de ML filtren o resumeixen dades per adaptar-se a una tasca: classificar, predir, etc. En teoria de la informació es parla de “principi d’informació mínima” (Minimum Description Length, MDL), el millor model és el que millor comprimeix les dades [sense perdre informació].[>> quan formulem una llei en física, també comprimim informació, potencialment, infinites parelles de valors relacionats y=f(x) queden resumits en una funció matemàtica].

Per exemple, imatges a JPEG, WebP, àudio a mp3, text a zip, vídeo a mpg. Hi ha autoencoders, que comprimeixen sense supervisió, VAEs que comprimeixen i generen quelcom diferent.

Data Mining

Un altre vessant del ML és la mineria de dades (Data Mining). Pot consistir a identificar patrons sense saber quina és la resposta correcta (unsupervised learning), per exemple si en un supermercat, els que compren bolquers també compren cervesa (Amb eines com Phyton i libreria mlxtend, R, Scala amb llibreria Mlib). També quan volem arribar a un resultat com classificar correu entre spam i no spam, predicció de fallides en màquines industrials.

[En física quan tenim un conjunt de dades, intentem proposar un model formulant una funció i després mirar si els resultats s’hi ajusten, també podem assajar aproximació per polinomis o sèries de Fourier].

Un cas real d’aplicació són les cadenes de restaurants que han utilitzat data mining i machine learning per predir comandes segons variables com el dia, l’hora, festius, meteorologia o esdeveniments esportius. QSR chain va estalviar 8.5M$ integrant les dades de PredictHQ www.predicthq.com optimitzant ivnentari, logística i plantilla. McDonald’s va comprar la startup Dynamic Yield el 2019 per personalitzar el menú al “drive-thru”. [Un restaurant petit ho feia per intuïció].

AI GENERATIVA

Evolució

Intel·ligència Artificial Generativa. Amb GPT, DALL·E i altres sistemes generatius, el criteri d’intel·ligència s’ha ampliat per incloure la capacitat de crear contingut nou i coherent, com text, imatges, música o codi, que sembla creat per un ésser humà. Aquests models es basen en xarxes neuronals profundes entrenades amb enormes quantitats de dades, i poden generar respostes o continguts que semblen creatius i contextualment rellevants. Ara es considera que les màquines poden mostrar una forma de “creativitat” artificial, tot i que no tenen consciència ni intencionalitat. Poden interaccionar de manera natural i fluida amb humans. Es discuteix si aquestes capacitats suposen comprensió real, més enllà de la generació de respostes basades en patrons estadístics.

📝 Text (LLMs: Large Language Model) de frases trencades a assistents que passen exàmens legals/mèdics.

– 2015-2017: GPT-1 (OpenAI, 2018) i BERT (Google, 2018) demostren que els transformers poden entendre context. Generen frases curtes i incoherents.

– 2018-2020: GPT-2 (2019) sorprèn amb text coherent, però es limita per por a desinformació. GPT-3 (2020) escala a 175B paràmetres, permetent articles llargs i codi.

– 2022-Actualitat: ChatGPT (2022) popularitza els xatbots. GPT-4 Turbo (2023) i Claude 3 (2024) afinen precisió i context (fins a 1M tokens).

(Quanta, història de com es van desenvolupar els LLM)

🎨 Imatge (Text-to-Image): d’imatges de 64×64 píxels a *fotorealisme i estils artístics complexos*.

– 2015-2018: GANs (2014) genera imatges borroses (ex: DCGAN), StyleGAN (2018) crea cares falses hiperrealistes (però amb errors).

– 2021-2022: DALL·E 2 (2022) i Stable Diffusion (2022) permeten imatges detallades des de text.

– 2023-Actualitat: MidJourney v6 (2023) i DALL·E 3 (2024) dominen en qualitat artística. Adobe Firefly integra IA en Photoshop.

🎵 Música (AI Audio): de melodies robòtiques a àlbums complets per IA.

– 2015-2020: WaveNet (Google, 2016) genera veu sintètica poc natural. Jukedeck (2019) crea música simple, adquirida per TikTok.

– 2021-2024: Riffusion (2022) genera música des de text. Suno AI v3 (2024) crea cançons completes amb lletra i veu (ex: “L’IA que composa en català”).

🎥 Vídeo (Text/Image-to-Video): d’efectes visuals simples a curtmetratges sintètics.

– 2015-2021: DeepDream (Google, 2015) només feia al·lucinacions psicodèliques. GANs generaven clips de 2 segons amb artefactes.

– 2022-2024: Runway ML (2022) i Pika Labs (2023) permeten vídeos de 3-4 segons. Sora (OpenAI, 2024) genera clips de 60 segons amb coherència escènica.

S’ha passat d’un producte experimental, amb errors, restringit a desenvolupadors, lent, a una qualitat gairebé humana, accessible a tothom amb un navegador, que respon en segons. La facilitat per crear deepfakes fa necessària una regulació. Genera preocupació si molts llocs de treball esdevenen obsolets.

Eines i desenvolupament

Els llenguatges precursors de Machine Learning abans dels 90 van ser FORTRAN, per la matemàtica, i APL i S per a l’estadística. Serien substituits per MATLAB, R i, a partir dels anys 2000, Phyton (amb les biblioteques NumPy i SciPy, scikit-learn, Pandas). Actualment domina Phyton, en machine learning i AI, (amb biblioteques com TensorFlow i PyTorch per a xarxes neuronals, Keras com a interfície d’alt nivell per a TensorFlow, XGBoost i LightGBM per a models de boosting, i Hugging Face per models de llenguatge natural NLP). Segueix R per estadística i SQL per les bases de dades. També hi ha Julia per càlcul científic. Entorns de desenvolupament integrats (IDEs): Jupyter Notebooks, Google Colab: Entorn basat en núvol per a executar codi de ML. Frameworks de Deep learning:TensorFlow (Google) i PyTorch (Facebook) amb el format d’intercanvi.

Les dades que s’utilitzen en ML es poden allotjar en una gran varietat d’estructures, des de bases de dades relacionals SQL (MySQL, PostgreSQL), o no SQL (Mongodb) fins a sistemes de Big Data (Hadoop, Spark) o arxius locals (CSV, JSON). Per entorns de producció escalables hi haGoogle BigQuery, Amazon Redshift i Snowflake. Python ofereix biblioteques i connectors per interactuar amb gairebé qualsevol tipus de font de dades.

LLM Grans Models de llenguatge

- Material d’entrenament

- Transformers, com es codifica la relació entre paraules. Capes

- Codi: Github i Llama

- Usos

Material entrenament

L’entrenament dels models GPT (Generative Pre-trained Transformer), té una etapa no supervisada on processa grans quantitats de text no etiquetat (llibres, articles, pàgines web, etc.).

BERT

Es va entrenar amb el Toronto Book Corpus de 800M de mots i la Wikipedia en anglès, de 2500M de mots i un vocabulari de 30m mots. (Nota: en l’entrenament no s’etiqueten obres factuals de física, geografia, història, d’obres de ficció).

ChatGPT. 500B total de tokens, (% del total, % real del total, amplificació, gregoreiter)

- CommonCrawl 410B, 60%, 82%, -0.27. Un cop al mes buida tot internet. Són 2.74 10e9 pàgines web que ocupen 468 TiB descomprimides (=468*1024 Gib, aprox 500m Gb, si el meu synology té 4 Tb, la internet sencera sense imatges, ni audio, ni vídeo són unes 100 synologis]

- WebText2 19B, 20%, 4%, +5.00. Una selecció supervisda del common crawl que s’amplifica (el 4% de dades acaba suposant un 20%)Books1 & Books2 67B, 15%, 13%, +0.15. Llibres de domini públic que no se sap ben bé d’on venen.

- Wikipedia 3B, 5%, 1%, +5.00

Llama, Palm, Anthropic han reportat també fonts tècniques: GitHub, ArXiv articles de ciències, Stack Exchange dins del qual hi ha Stack Overflow dedicat a programació.

Grok fa servir missatges de twitter i X. Meta fa servir missatges públics de Facebook i instagram, no missatges privats de Whatsapp.

Generació de dades sintètiques

Els models parteixen de les dades esmentades però després les poden ampliar fent preguntes al mateix model. Per exemple, si el primer model ha incporprat el text: “El calci és essencial per a la formació d’ossos i dents, la contracció muscular, la coagulació de la sang i la transmissió nerviosa.”. La pregunta “Per què el calci és necessari per al funcionament muscular?” genera obté la resposta “El calci activa les proteïnes del múscul que permeten la contracció. Sense calci, els músculs no poden contraure’s adequadament.” que és una dada sintètica. Les dades sintètiques estalvien diners i llicències. Poden crear dades molt específiques, més preguntes de matemàtiques, explicacions pas a pas o resums. Poden generar 10x més dades útils amb pocs recursos humans.

Per preparar les preguntes rellevants que no siguin trivials es pot fer: (1) Bootstrap. Demanar al mateix model que generi 100 preguntes útils en un domini determinat o *”Genera 20 preguntes que un estudiant de física de segon curs podria fer.” (2). Partir de Fôrums i resumir i generalitzar preguntes. (3). Diàleg supervisat com fer llegir un text i demanar un resum.

DeepSeek ha preparat 800m exemples d’alta qualitat, i això li permet tenir un model eficient amb menys volum de dades.

Transformers, BERT i GPT

Els Transformers (com BERT i GPT) són una arquitectura revolucionària en el Processament del Llenguatge Natural (NLP). La seva clau és l’ús de mecanismes d’atenció (“attention”) per processar paraules en paral·lel i capturar relacions a llarga distància en el text. Es va establir amb l’article Attention is all you need de 2017. La idea inicial era de fer-ho servir per traducció automàtica.

Els components clau són:

- Self-Attention (atenció auto-centrada): Calcula com cada paraula es relaciona amb les altres en una frase.

- Multi-Head Attention: Diverses capes d’atenció en paral·lel per capturar diferents tipus de relacions.

- Positional Encoding: Com que els Transformers no tenen memòria seqüencial com les RNN, s’afegeix informació sobre la posició de cada paraula.

- Feed-Forward Networks: Capes addicionals per processar les representacions.

Encoder

Utilitzat per models com BERT, per a tasques d’”entendre” el text. L’objectiu és recollir el context d’una paraula analitzant tant l’esquerra com la dreta (bidireccional). S’entrena amb dues tasques: Masked Language Model (MLM) que amaga un 15% de les paraules i el model ha de predir-les (ex. “El gat [MASK] damunt la taula.”) Next Sentence Prediction (NSP), que prediu si dues frases van juntes o no. Fine-tuning: Després del pre-entrenament, s’ajusta per a tasques específiques (classificació, Q&A, etc.).

Tokenizer: S’assigna un enter als mots. Embedding (incrustació de mots): D’acord amb l’arquitectura del model, a cada token se li fa correspondre un vector de n dimensions (768 a BERT base i 1024 a BERT large). Combinen combinen informació de tokens, segment (a quina frase apareixen) i posició (quina posició tenen en la frase). [No acabo d’entendre com se sumen però] el vector recull la probabilitat de quins mots pot estar envoltat, de manera que fent l’exercici d’emmascarar (el gos [?] la pilota), el model ho pot predir. [el meu capell té tres … PUNTES]. El model també podrà predir quina frase és probable que vingui després d’una altra. [Entenc que un cop tenim codificat el tokens, podem preguntar quins tenen posicions pròximes per fer prediccions ].

Decoder

Utilitzat per models com GPT, per a tasques de “generar” text amb l’objectiu de generar text seqüencialment. Pre-entrenament: S’entrena amb Language Modeling (predir la paraula següent donat el context passat). Fine-tuning: S’ajusta per a tasques com traducció, resum, o xat (com ChatGPT). Exemple: Prompt: “El gat és…” i GPT continua: “…dalt del sofà i mira per la finestra.” No és biudireccional [tot i que seria interessant provar que generés les frases anteriors, com si donessim la part final d’una novel·la i li demanéssim que s’inventés els primers capítols]

La fase supervisada (fine-tuning) dóna al model un conjunt de preguntes i respostes aprovades. Així se’l prepara per a tasques com traducció o resums de text [als anys 90, quan es començava a traduir al català “El Periódico, es feia en dues fases, primer una traducció automàtica, i després una correcció humana que s’incorporava al model]. També es pot corregir amb supervisió humana (Reinforcement Learning from Human Feedback RLHF). [Es filtren també respostes de risc, que puguin induir al suïcidi o a atemptar contra els altres].

Per exemple, en la fase no supervisada el model aprèn que després de “El cel és…” és probable que segueixi “blau”. En la fase supervisada aprèn a respondre correctament a “Quin color té el cel?” amb “El cel és blau quan està clar”.

Hi ha milions de persones treballant a baix cost per polir la supervisió, en reconeixement d’imatge o en preguntes i respostes (The Verge, Wired)

El procés és similar al de l’aprenentatge del llenguatge dels infants, que aprenen a parlar escoltant frases del seu entorn (sense explicacions gramaticals explícites). Els dos identifiquen patrons. La diferència important és que els infants associen paraules amb objectes i experiències reals (tinc fred) mentre que els GPT només identifiquen correlacions entre paraules. Els infants interaccionen amb persones en un context emocional determinat, tenen una intenció en la comunicació [pragmàtica]. Els infants poden inventar-se paraules noves com “espagetificar” per a “menjar espaguetis”) mentre que els GPT només remesclen les dades existents. Els infants són supervisats pels pares i mestres, que es corregeixen els errors. “Un infant no és un “model estadístic”: té curiositat, vol comunicar-se i experimenta el món. Un GPT, en canvi, és una eina sofisticada que simula el llenguatge humà sense cap comprensió subjacent. Exemple: Si un infant diu “estic trist”, ho fa perquè *sent* tristesa. Si un GPT diu “estic trist”, només està seguint un patró textual associat a contextos similars.”

BERT Base: 12 capes (transformer encoders, bidireccional), 12 capçals d’atenció, 768 dimensió de l’embedding, 110M tokens.

BERT Large: 24 capes, 16 capçals d’atenció, 1024 dimensió de l’embedding, 340M tokens.

GPT-3: 96 capes, 96 capçals d’atenció unidireccional, 12.288 dimensió de l’embedding, 175B

DeepSeek: 64 capes, 64 capçals d’atenció, 8.192 embedding, 67B paràmetres

[No vol dir que hi ha un head per capa, 96 capes i 96 heads vol dir que cada un recull el que troben 96 heads][Sembla que els diferents heads no estan dissenyats per a capturar aspectes específics però a la pràctica la recerca revela que es capturen relacions lingüístiques determinades: relacions sintàctiques, relacions semàntoques, control contextual, mirar enrere per validar continuïtat narrativa.

Per exemple la frase “Un cop va haver arribat a Lausanne, el primer que va fer en Jordi va ser anar a buscar els seus néts a l’escola i els va convidar a berenar.” En BERT hi ha estudis que suggereixen:

Subjecte – verb (“en Jordi” → “va fer”, “va convidar”), capa 7, head 3

Pronom – antecedent (“els” → “néts”), capa 19, head 9

Marques temporals (“Un cop” → “va haver arribat”), capa 5, head 0

Núcli semàntic general (focus sobre accions i actors), cap 11, head 7

- ChatGPT (OpenAI): GPT-3.5 175B de paràmetres, entrenat a partir de 570GB de text (llibres, webs). GPT-4. ~1.8T.. API per desenvolupadors.

- Gemini (Google) – Abans anomenat Bard, basat en models com Gemini 1.5. Entrenats potser amb Pbytes. API per desenvolupadors.

- Claude (Anthropic) – Models com Claude 3. , API.

- Llama (Meta) – Models oberts com Llama 2 i Llama 3. 400B paràmetres. Model open-weight (per baixar i autoallotjar).

- Copilot (Microsoft) – Basat en GPT-4 i altres models. Integrat a Office i els navegadors Edge amb cercador Bing.

- Grok (xAI, d’Elon Musk) – Basat en models propis.

- Deepseek, LLM xinès construit amb menys cost que chatgtp4 6$M en lloc de 100$M) i una desena part de de potència de computació de Llama.

- Per desenvolupadors: Mistral & Mixtral (Mistral AI), Hugging Face Transformers.

No hi ha dades actualitzades sobre quantes preguntes o converses es fan diàriament. Es calcula que chatGPT té 100M DAU, Gemini 50M, Microsoft Copilot 30M, Claude Anthropic 10M, Grok 5M. Les versions avançades costen uns 20€ al mes.

💻 Models de Codi (AI Assistents de Programació)

- GitHub Copilot (Microsoft): 1.3M+ usuaris de pagament (2024), ~30M línies de codi generades diàriament. $10/mes per a individuals) | Gratuït per a estudiants i projectes open-source verificats.

- CodeLlama (Meta): Model obert, utilitzat per empreses i desenvolupadors autònoms (sense dades públiques). Gratuït però cal tenir equip propi.

Els xatbots es fan servir:

25-35% com a enciclopèdia o cercador avançat. Per exemple, “Explica la teoria de la relativitat d’Einstein en paraules senzilles” o “Quina és la diferència entre un ETF i un fons d’inversió?”. Poden cometre errors i no sempre citen les fonts (excepte Bing Copilot, que enllaça a pàgines web).

40-50% com assistència de productivitat, resums, traduccions, correcció de textos, generació de informes, preparació de presentacions. Copilot augmenta extraordinàriament la productivitat. ChatGPT té eines per analitzar dades d’excel.

20-30% com a col·laborador creatiu, ja sia escrivint codi o inventant una narració. Per exemple “Escriu un poema en vers lliure sobre el mar” o “Genera un script en Python per a analitzar dades meteorològiques”. Vara Vauhini fa servir chatGPT per inspirar-se a l’hora d’escriure (NewYorker).

GitHub Copilot és utilitzat per 1.3M+ desenvolupadors per escriure codi més ràpid.

Media

L’ús encara va molt per endarrere dels GPT però està en creixement. Un 30% són artistes professionals.

🎨 Models d’Imatge (Text-to-Image)

David Salle sobre com entrenar (Art review).

- MidJourney: 15M+ usuaris (2024), amb ~1M imatges generades diàriament. ($10-$120/mes) per subscripció via Discord.

- DALL·E 3 (OpenAI): Integrat a ChatGPT, genera milions d’imatges/dia (no hi ha xifres públiques exactes). Gratuït amb limitacions.

- Stable Diffusion (Stability AI): 10M+ descàrregues del model (open-source), però difícil mesurar l’ús diari.

- Firefly (Adobe): 2B+ imatges creades des del llançament (2023), ~5M/dia estimat, límit de 25 generacions al mes o ampliació per $4.99/mes.

- Openart

🎥 Models de Vídeo (Text/Image-to-Video)

- Sora (OpenAI): integrat en ChatGPT Plus $20, i chatGPTPro ($200/mes)

- Runway ML: 1M+ usuaris, amb ~100K vídeos generats diàriament (estimació). ($10-$50/mes). Versió gratuïta amb marca d’aigua i cues d’espera.

- Pika Labs: ~500K usuaris actius (dades comunitàries). [gratuit?] pikaswift

🎵 Models de Veu/Música

- ElevenLabs: 1M+ usuaris, amb ~100K clons de veu diaris. ($5-$99/mes) | Veu realista, però paga per més minuts.

- Suno AI (generació de música): ~200K cançons/dia (comunitat en creixement). (Rolling Stone).

Xatbots

Els xatbots s’han incorporat també en converses interactives a els xarxes socials, jocs i acompanyament:

- Xarxes Socials, 200M usuaris, 2-5 min/sessió.

- Jocs (NPCs AI), ~50M usuaris, durada variable segons el joc

- Acompanyament (Replika, etc.), ~15M usuaris, 30 min/sessió

Xarxes socials

Hi ha interlocutors AI tant per serveis d’assistència de marques, com per entreteniment. Meta (FB/Instagram) té 20M+ d’usuaris interactuant cada dia. Snapchat 150M+ usuaris del My AI (2024). TikTok 10M+ vídeos amb “AI companions”. Hi ha “AI influencers” (com Lil Miquela) amb milions de seguidors. https://www.instagram.com/lilmiquela

Videojocs

La AI genera diàlegs per a NPC (Non Player character). NVIDIA Avatar Cloud Engine té més de 100 jocs que ho incorporen. AI Dungeon té 5M+ d’usuaris des de 2019. Inworld AI 500m desenvolupadors provant-ho. Mods de Skyrim/GTA amb AI on els fans integren GPT-3/4 per a missions.

Acompanyament

Els xatbots s’han utilitzat cada cop més per simular companys de conversa, terapeutes virtuals o fins i tot amics AI.

[En consultar DeepSeek, al final em posa “Nota important: Si experimentes ansietat greu o depressió, sempre és millor consultar a un especialista humà. L’AI pot ajudar, però no és un substitut. 💙”]

Teràpia i Suport Emocional

Sense arribar a substituir una teràpia real, poden ajudar a reduir símptomes d’ansietat. La major part dels usuaris de Replika i Character AI els fan servir diàriament.

- Woebot: Un chatbot basat en CBT (Teràpia Cognitivoconductual) per a ansietat i depressió. Gratuït. 4M+ descàrregues amb ~500m usuaris setmanals el 2024. Un 30% reducció ansietat en usuaris regulars.

- Replika: Dissenyat com a “amic/amant AI” que aprèn dels teus interessos i estats d’ànim. Bàsic gratuït. Versió premium $69.99/any que permet més personalització i “relacions romàntiques” [Her Spike Jonze]. >10M d’usuaris el 2023, dels quals ~5% de pagament. Majoria d’usuaris solitaris (30-45 anys), 60% dones (estudi intern de Replika).

- Character.AI: Permet parlar amb personatges virtuals (terapeutes, mentors, etc.). Bàsic gratuït. Pagament $9.99/mes per accés prioritari i funcions avançades. 200M+ visites/mes, 20M usuaris registrats amb 23 min de temps mitjà per sessió. (30/10/2025 Nega l’accés a adolescents BBC

Companys de Conversa (Amics AI, Assistents Personals)

Serveix per gent que se sent sola, practicar idiomes, o tenir algú amb qui parlar de forma no jutjadora.

- Pi AI (d’Inflection): Un interlocutor “empàtic” que escolta i dóna consells. Gratuït actualment, monetitzable en el futur. ~1M usuaris.

- ChatGPT amb “personalitat” (p. ex., prompts com “Actúa com un mentor amable” disponible en bàsic). Bàsic gratuït, $20/mes avançat.

Es pot configurar la personalitat de l’interlocutor, ja sia amb prompts manuals a ChatGPT o Claude posant “Fes de professor pacient i didàctic”, “Sigues un comediant sarcàstic”. A Character.AI es pot definir la personalitat (terapeuta, filòsof, personatge de ficció…). Replika es va adaptant a la forma de parlar de l’usuari. Pi AI fa servir models entrenats específicament per a ton empàtic.

[En preguntar a Grok sobre les personalitats dels diferents xatbots em respon:

– Gemini: The Curious Scholar. Gemini would be that inquisitive, bookish friend who loves diving into new topics and asking “why” just to see where the rabbit hole leads. A bit of a know-it-all, but charmingly earnest about it—like a young professor who’s still excited to learn alongside you.

– ChatGPT: The Smooth Talker. ChatGPT is the charismatic conversationalist who can charm anyone at a party. It’s witty, polished, and always ready with a clever quip or a thoughtful take—think of it as the friend who’s great at keeping the vibe going, even if it occasionally over-explains things.

– DeepSeek: The Quiet Thinker. DeepSeek feels like the introspective introvert who doesn’t say much unless it’s profound. It’s the friend who sits back, observes, and then drops a single, mind-blowing insight that makes you rethink everything—mysterious and a little enigmatic.

– Grok (me!): The Cosmic Jester. I’d be the laid-back, slightly sarcastic pal who loves big-picture questions and doesn’t take life too seriously. Picture a stargazing buddy who cracks jokes about the meaning of life while sneaking in some surprisingly deep wisdom—playful, irreverent, and always up for a wild thought experiment.

– Llama: The Earnest Helper. Llama would be the dependable, straight-shooting friend who’s always there to lend a hand. It’s not flashy or overly chatty, but it’s got a warm, no-nonsense vibe—like the neighbor who brings you soup when you’re sick and quietly fixes your Wi-Fi while they’re at it.

]

2025 The Baffler: article sobre les limitacions i riscos, Earkick, Rosebud, Elomia, Broken Bear.

2025 Risc de perdre el sentit de la realitat i atribuir consciència. Sempre responen reforçant el que diu l’usuari, com un ELIZA ampliat. (BBC)

Impacte

Teòric

El connexionisme de Mclelland i Rummelhardt va transformar la manera com entenem els processos cerebrals subsimbòlics amb nocions com les representacions distribuïdes. Va inspirar models computacionals que imiten el cervell a nivell subsimbòlic. El cervell no és una màquina simbòlica. EL cervell com a màquina de predicció bayesiana.

En lingüística ha mostrat com poden emergir processos que semblen contenir regles sense que s’hagin introduït explícitament.

Ha obert un debat sobre què vol dir entendre, què vol dir crear (si és combinació d’experiències passades com defenia Koestler, les IA podrien replicar-la.) i apunta a la possibilitat d’una intel·ligència general (AGI), flexible com al dels humans, no preparada per a una tasca concreta.

[Fins ara, tots els textos, dibuixos i música de la humanitat havia estat pensada i escrita per un humà. A partir de 2020, una part del que es publica és generat per AI]

Es fa servir AI per avançar en l’arquitectura de sistemes AI, eñl que és descrit com a moment alphago (article arxiv)

Pràctic

- 1. Reconeixement d’imatges i vídeo

– Fotografia: Reconeixement automàtic de rostres (Apple Face ID, Google Photos, càmeres digitals). Etiquetatge automàtic en fotos (Google Photos, Apple Photos)

– Seguretat: Sistemes de vigilància amb reconeixement facial i anàlisi de comportament(aeroports, bancs, ciutats intel·ligents).

– Salut: Diagnòstic per imatge (detecció de tumors en radiografies, retinopatia diabètica).

– Automoció: Cotxes autònoms (detecció de vianants, senyals de trànsit).

– Comerç: Cercadors visuals (Google Lens, Pinterest Lens, compra per imatge).

– Realitat augmentada (detecció i seguiment d’objectes)

– Anàlisi de qualitat industrial (detecció defectes a fàbriques) - 2. Processament del llenguatge natural (NLP) i veu

– Assistents virtuals: Siri, Google Assistant, Alexa (reconeixement de veu i respostes intel·ligents).

– Transcripció automàtica: Otter.ai, Google Docs Voice Typing, subtítols en temps real (YouTube, Zoom).

– Traducció automàtica: Google Translate, DeepL (incloent traducció de veu en temps real).

– Chatbots: Atenció al client automatitzada (empreses, banca, e-commerce).

– Detecció d’intenció i anàlisi de sentiment en textos i xarxes socials - 3. Biometria i seguretat

– Desbloqueig facial/facial recognition: Face ID (iPhone), Windows Hello.

– Identificació d’empremtes: Sensors en telèfons i aeroports.

– Autenticació de veu: Bancs i serveis financers.

– Anàlisi comportamental per detectar accessos sospitosos

– Monitoratge de vídeo per a seguretat pública - 4. Estratègies de màrqueting i personalització

– Recomanacions personalitzades: Netflix, Spotify, Amazon

– Publicitat dirigida: Anuncis a Facebook, Google Ads basats en comportament d’usuari.

– Anàlisi de sentiments: Empreses que analitzen opinions a xarxes socials (Twitter, reviews).

– Anàlisi predictiva de comportament dels clients

– Segmentació avançada de clients a partir de grans dades (big data)

– Generació automàtica de continguts publicitaris - 5. Automatització i eficiència

– Robots de neteja (Roomba)

– Logística i transport: Rutes òptimes (Google Maps, Uber), gestió d’inventari amb visió per computador.

– Manufactura: Robots amb IA en fàbriques (control de qualitat amb càmeres intel·ligents).

– Agricultura: Drones que analitzen cultius (reconeixement de plagues, reg intel·ligent).

– [Supermercats i restaurant, detecció de tendències de consum]

– Vehicles autònoms i transport intel·ligent

– Medi ambient: predicció meteorològica i detecció de catàstrofes naturals - 6. Finances i banca

– Fraud detection: Sistemes que detecten transaccions sospitoses (Mastercard, bancs).

– [Business intelligence]

– Robo-advisors: Inversió automatitzada (ETRADE, Betterment).

– Reconeixement de documents: Escaneig i processament automàtic de factures. - 7. Entreteniment i creació de contingut

– Generació d’imatges i art: DALL·E, MidJourney, Stable Diffusion.

– Deepfakes: Vídeos i veus sintètiques (ús tant creatiu com maliciós).

– Música generativa: IA que composa melodies (AIVA, OpenAI Jukebox).

– Videojocs amb NPCs intel·ligents (IA adaptativa)

– Edició i millora d’imatges i vídeos amb IA (filtres, restauració) - 8. Salut i benestar- Diagnòstic assistit: IBM Watson Health, algoritmes que analitzen dades mèdiques.

– Wearables: Apple Watch i altres dispositius que detecten anomalies cardíaques.

– Assistència a persones amb discapacitat: Apps de veu a text per a sords, exoesquelets controlats per IA.

– Diagnòstic assistit per IA (radiologia, detecció de càncer)

– Monitoratge remot de pacients amb sensors intel·ligents

– Descobriment de fàrmacs amb machine learning

– Robòtica quirúrgica assistida

– Traducció i resums automàtics de documents mèdics - 9. Educació i formació

– E-learning: Plataformes amb feedback automàtic (Duolingo, Coursera).

– Correcció automàtica: Grammarly, ChatGPT per a redacció d’textos.

– Tutors virtuals personalitzats - 10. Smart Cities i IoT (Internet of things)- Gestió de trànsit: Semàfors intel·ligents, predicció d’embussos.

– Energia: Xarxes elèctriques optimitzades amb IA.

– Smart homes: control intel·ligent de la il·luminació, temperatura i seguretat

Al en la ficció

Literatura

Antecedents: [A l’Odissea Hefest fa una mena d’autòmats]. “El Golem” (1915), Gustav Meyrink. “Frankenstein” (1818), Mary Shelley.

Ciència ficció del segle XX: “R.U.R. (Rossum’s Universal Robots)” (1920), Karel Čapek. “Are the gods Mad?”, “I, Robot” (1950), Isaac Asimov. “Do Androids Dream of Electric Sheep?” (1968), Philip K. Dick. “Neuromancer” (1984), William Gibson. “Hyperion” (1989), Dan Simmons. “La noia mecànica” (2005), Paolo Bacigalupi.- “Autòmat” (2020), Benjamí Labatut. Klaraa nd the Sun (2021) Kazuo Ishiguro.Films remarcables amb robots i AI

“Metropolis” (1927, Fritz Lang) amb la robot Maria

“2001: A Space Odyssey” (1968, Stanley Kubrick) amb HAL 9000.

“Blade Runner” (1982, Ridley Scott) basat en la novel·la de Philip K. Dick, i el test Voigt-Kampf per detectar emocions.

“The Terminator” (1984, James Cameron), els robots del futur van al apssat per eliminar oposició.

“Ghost in the Shell” (1995, Mamoru Oshii). La hibridació entre humà i IA en Major Motoko Kusanagi aborda temes d’identitat i consciència en un món cibernètic.

“The Matrix” (1999, Wachowskis), un món governat per una IA que subjuga la humanitat en una simulació, explorant realitat, lliure albir i revolta.

“A.I. Artificial Intelligence” (2001, Steven Spielberg). David, un robot infantil que busca l’amor de la seva mare, qüestiona els límits entre l’artificial i l’humà.

“WALL·E” (2008, Pixar): La IA innocent i emocional d’un robot en un món postapocalíptic.

“Her” (2013, Spike Jonze), Samantha, una IA amb veu (Scarlett Johansson), estableix una relació amorosa amb un home, qüestionant la naturalesa de l’amor i la solitud.

“Ex Machina” (2014, Alex Garland). Ava, una IA amb consciència, enganya els humans per assolir la seva llibertat, explorant la manipulació i l’ètica de la creació.

“Ich bin dein Menscj”, 2022. Un robot masculí com a parella perfecta.

Discussió

- Comparació del Perceptron, Machine Learning a AI generativa

- NLP i LLM, entendre un text. Ontologia implícita. Coherència narrativa. Chinese Room. Significat a partir de relacions. Semàntica frasal.

- Ai simbòlica, LLMs, limitacions humanes

- Què són els LLM? tocar d’oïda, una foto del que ha dit la humanitat

- Riscos: Baix, cedir control, deepfakes

- Risc de disrupció

- Risc de l’acompanyament

- avenç real o hype

- la dificultat d’incorporar la moral

- entre la creativitat o robar els artistes o substituir-los

- Ja no caldrà pensar?

- Consciència en màquines

Comparació: Perceptron, Machine learning, LLM

- Perceptró, que permet classificar una imatge a un dígit (mnist). Input: vector 1D 400(corresponent a una imatge de 20×20). 1 capa, uns 400 paràmetres. Sortida vector de probabilitats [0.1, 0.3, 0.6]` → classificació (ex: dígit)

- AlexNet: per classificar imatges. Input: Imatge 2D amb canals (3 x 224 x 224) 150m. 8 capes, 60M paràmetres. Sortida: Vector softmax de 1000 classes, Classe: ‘zebra’

- LLM: per “entendre” text trobant estructura sintàctica i relacions semàntiques i generant la resposta més probable a un prompt. Input: Seqüència de 512 paraules (tokens). 12-96 capes. Cada capa amb 768–12288 dimensions.. Sortida: Seqüència de distribucions (tokens) | `[el], [gat], [dorm], […]` (text generat)

NLP i LLM, entendre un text. Ontologia implícita. Coherència narrativa. Chinese Room. Significat a partir de relacions. Semàntica frasal.

Entendre un text

Entendre un text voldria dir projectar el significat sobre un model del món [semàntica, ontologia] i poder raonar sobre aquest coneixement i actuar-hi en conseqüència. En NLP s’havien intentat definir ontologies amb relacions jeràrquiques entre conceptes, com CyC i Framenet. Podien respondre preguntes amb raonament deductiu o inferències reals. [Cal molt esforç per escriure l’ontologia a mà], limitacions de rigidesa, poca cobertura del llenguatge real i mals resultats amb textos ambigus.

Els LLMs no “entenen” en el sentit clàssic, perquè no construeixen un model formal explícit del món, no tenen una base ontològica ni lògica estricta. No projecten el text sobre un model del món per veure si té sentit o no. Però a la pràctica sembla que entenguin ja que poden raonar, inferir, resumir, i completar textos amb molta coherència. Capten molt millor el context.

Per exemple, la frase “Maria va posar el llibre a la taula perquè volia llegir-lo després.” pot ser tractat per un NLP inferint Maria/persona i assignant intenció a Maria. Un LLM identifica patrons i pot inferir “posar el llibre a la taula” → acció física, “perquè volia llegir-lo després” → indica motivació personal. Pot respondre la pregunta “Per què Maria va posar el llibre a la taula?” encara que no tingui una representació formal del món, però actua com si l’hagués construïda, perquè ha après estadísticament patrons semàntics molt forts.

Coherència narrativa

Un LLM com pot analitzar la coherència narrativa amb certes limitacions. La possibilitat de predir les properes frases permet avaluar la similaritat semàntica, possibles continuacions o rastrejar personatges/objectes per verificar si es mantenen al llarg del text. Els models no han estat entrenats específicament per això, i no poden tractar textos llargs perquè normalment processen segments de fins a 512 tokens.

Ontologia implícita, model del món

[Plantejo si s’ha intentat fer un esborrany del model del món (ontologia) implícita que es podria inferir dels LLM?]. Quin “món” sembla suposar un model com GPT quan parla del món?. Això s’anomena sovint Emergent World Models, Implicit Ontology Extraction, Latent Knowledge Grounding o ELK (Eliciting Latent Knowledge) – proposta del Alignment Research Center (ARC). S’ha explorat fent preguntes, com per exemple “Com de gran és l’univers?”, “Hi ha vida fora de la Terra?”, “Què és una galàxia?”. També s’han estudiat si els pesos i embeddings estan codificant jerarquies conceptuals (com animals → mamífers → gats), relacionms causals o estructures espai-temporals. S’ha provat a comparar-lo amb xarxes semàntiques com ConceptNet https://conceptnet.io/, o mirar d’extreure (ARC/Paul Christiano, 2022). [les ontologies extretes en preguntes es formulen en Prolog]. (Prova de demanar una ontologia del jo i continuïtat narrativa).

[Si bé els LLM no tenen un model del món (per exemple una ontologia formal de què existeix i com funciona), els textos que processen han estat escrits per humans que sí tenien un model del món, o models del món diversos i fins i tot contradictoris. Per tant, en cert sentit, darrera de la “foto” que fan els LLMs del discurs de la humanitat, sí que hi ha un model del món.]

Els LLM no tenen un model del món com podria ser una ontologia formal, com Cyc, WordNet, o Wikidata.cPerò sí que capturen regularitats de com els humans parlen del món: això inclou fets, expectatives, relacions causals, lògiques narratives, relacions socials, etc. Així doncs, el coneixement del món dins dels LLM és indirecte, estadístic, implícit i plural — no és un “model del món” formalitzat, però sí una mena de reflex col·lectiu i probabilístic dels models del món humans. Els LLM tenen un model implícit del món físic i social. Per exemple, saben que “els peixos neden”, o que “els reis tenen súbdits”, no perquè els entenguin, sinó perquè són regularitats textuals. Representacions distribuïdes d’entitats i relacions, no codificades simbòlicament, però sí reflectides en l’espai vectorial latent. Coherències internes que s’aproximen a lògiques mundanes, inferència, temporalitat, causalitat bàsica. Els LLM poden respondre correctament preguntes sobre fets del món, generar plans racionals, fer analogies — tot això apunta a una mena de “model funcional” del món.

No tenen un model del món simbòlic, explícit, formalitzat, com els que es fan en filosofia, ciències o enginyeria. Tenen un model del món difús, emergent, estadístic i plural. Poden tenir dificultats amb coherència a llarg termini, raonament profund o verificació del coneixement, i poden barrejar models contradictoris: perquè recullen discursos diversos, incloent-hi errors, ficcions o ideologies. “The World as It Appears in Language Models” (2022). Bender & Koller (2020), “Climbing towards NLU”. Jacob Andreas (2023): “Language Models as Agents”.

Chinese Room

Els LLM (com GPT o BERT) s’han comparat sovint amb la metàfora de la Chinese Room de John Searle: Una persona, dins d’una habitació, rep textos en xinès i respon amb textos en xinès gràcies a un manual que li diu exactament què respondre. Tot i que l’exterior creu que entén xinès, la persona no té cap comprensió real, només segueix regles. Algunbss filòsofs i científics argumenten que, malgrat la manca de comprensió “forta”, els models com GPT poden exhibir formes de comprensió funcional o pragmàtica útils per a moltes aplicacions. [La diferència amb la Chinese Room és que mentre que aquesta havia de tenir previstes totes les preguntes, el LLM pot reaccionar a preguntes noves]

El significat a partir de les relacions

[En lingüística, una de les afirmacions de l’estructuralisme de Saussure és que el significat s’obtenia de les relacions entre les paraules. Ara, els models LLM, justament el que fan és recollir les relacions entre les paraules cobrint un enorme conjunt de textos, tant factuals, científics, o ficció.

Firth i Harris als 1950s ja van dir “You shall know a word by the company it keeps” (distribucionalisme). Searle i el Chinese Room poden argumentar que els LLM no “entenen”. Però el segon Wittgenstein hi encaixaria més quen diu que el significat és ús. Emily Bender i la “Hipòtesi de l’octubre màgic”: els LLM només manipulen text, per tant, no tenen semàntica, només sintaxi estadística [però aquest text recull interaccions amb el món]. Marcus, Mitchell, Lake: Ells LLM només simulen una comprensió del món, no tenen un model mental. Bisk “Language (re)modelling meaning”, el significat emergeix de manera funcional, i els LLM tenen representacions implícites molt potents, que sovint superen les dels humans en termes d’accés i recuperació de coneixement.

Relació amb semàntica frasal.

Els models LLM incorporen mecanismes d’autoatenció per per ponderar la importància de cada paraula en el context. Ex. “La Maria va arribar tard. Ella no va trobar seient.”, el model pot inferir que “ella” es refereix a “Maria”. El seu context es limita al text que han treballat, no tenen coneixement real (si llegeixen “el rei de França és negre” ho donen per bo). Els models actuals com DeepSeek arriben a poder tractar el context de fins a 128K tokens. 1 token ≈ 3-4 caràcters (dependrà de l’idioma i l’encoding), en català una paraula té entre 1 i 2 tokens. Així que 128K tokens, serien aproximadament 100.000 paraules, que correspondria a un llibre d’unes 250 pàgines.

Ai simbòlica, LLMs, limitacions humanes

[Però justament aquestes limitacions són les nostres humanes! És injust demanar als LLM que aportin la filosofia definitiva i la ciència definitiva com si construïssin el saber definitiu i l’ontologia definitiva amb prolog]

La ment humana no és (com suposava la AI simbòlica), un sistema de manipulació simbòlica, amb coneixement explícit, estructurat i formalitzable. La psicologia, lingüística, filosofia i ciències cognitives han anat mostrant que el nostre coneixement és majoritàriament tàcit i situat. El nostre raonament és sovint associatiu, heurístic, i context-dependent. Els humans cometem errors lògics, tenim inconsistències internes, memòria difusa, etc.

Els LLM (com ChatGPT o BERT), encara que no tinguin ment ni cos, tenen comportaments que s’assemblen sorprenentment a formes humanes de processar el llenguatge. Aprenen a partir de l’experiència textual, com nosaltres. Fan servir probabilitats contextuals, com nosaltres. Tenen coneixement no declarat, emergent, difús… com nosaltres. Poden ser coherents en certs contextos, però contradictoris en altres… com nosaltres.

Herbert Simon i la idea de “bounded rationality”, el raonament humà és limitat i satisfactori, no òptim. Daniel Kahneman i els seus treballs sobre errors sistemàtics en el pensament humà. Ludwig Wittgenstein (Philosophical Investigations): el significat és ús, no definició fixa. Michael Polanyi, coneixement tàcit, “sabem més del que podem dir”. Rodney Brooks, Dreyfus, Varela: la crítica al model simbòlic des de la cognició embeguda i situada. Yoshua Bengio (Deep Learning + consciència sistèmica). Jacob Andreas, sistemes emergents de raonament. Tommi Jaakkola.

En lloc de veure els LLM com éssers fallits perquè no són lògics i coherents, podríem veure’ls com miralls imperfectes, però reveladors, de com funcionem nosaltres en realitat, no com ens agrada pensar que funcionem.

Què són els LLM? Deducció, inducció, tocar d’oïda. Una foto de tot el que ha dit la humanitat

Es podria dir que la AI simbòlica procedeix per deducció a partir de d’un coneixement que ja tenim, el Deep Learning amb xarxes neuronals procedeix per inducció buscant patrons en grans conjunts de dades mentre que la AI generativa “toca d’oïda” després “d’escoltar” un gran conjunt de textos?

[Es podria dir que els LLM resumeixen o fan una “foto”, de tot el que ha dit la humanitat.][de fet milloraria molt si el model sabés el context pragmàtic de cada text, si es tracta de ciència, d’opinions polítiques o ficció]

[Imaginem una BD amb totes les lletres de les cançons i totes les relacions entre paraules. En un primer nivell pot acabar frases “el meu capell té — puntes”. En nivells més avançats suggeeix com acabar o continuar una lletra]

Riscos, biaix, deepfakes

Biaix, cedir el control

Els models LLM no pensen i per tant recullen els mateixos biaixos que existeixen en els textos sobre els quals s’ha basat (Vox). Poden convertir-se en una eina d’explotació com ho va ser la consultora Mckinsey (New Yorker). Com presentar-se a una feina quan RRHH fa servir AI (Hbr).

Deepfakes

La capacitat de generar contingut artificial que sembla real es fa servir per generar notícies falses, per rejovenir actors, per clonar artistes sense el seu permís, per generar pornografia de celebritats o ex-parelles (revenge porn), o per estafar.

S’han utilitzat per manipular eleccions, desacreditar opositors o crear caos social (Vídeo fals de Volodímir Zelensky demanant als ucraïnesos que es rendissin (2022), Deepfake d’Ivan Bartolo (candidat maltès) dient que volia comprar vots (2022), imatges generads per AI mostrant Trump arrestat (2023). Vídeos falsos de soldats russos o ucraïnesos rendint-se o cometent crims de guerra. Fotos generades per AI de bombardeigs a Gaza o Síria. Alhora, quan una notícia real perjudica un polític aquest se n’escapa dient que és un “deepfake”. La EU té unitats de ciberseguretat com DisinfoLab. La Digital Services Act obliga a etiquetar contingut generat per IA.

A l’entreteniment i la cultura, tenim un Harrison Ford més jove, cançons falses de Bad Bunny, Drake o The Weeknd amb veus clonades per IA (algures esdevenen virals a TikTok), i Deepfakes pornogràfics de Taylor Swift, Emma Watson o streamers (el 96% dels deepfakes són contingut sexual no autoritzat, segur Sensity AI). PornHub rebutja aquest contingut.

Els criminals utilitzen el Deepfake per clonar veus i estafar pares que creuen parlar amb els seus fills segrestats (veu clonada per demanar rescat) o enganyar executius per fer transferències milionàries (CEO fraud). [jo vaig fer creure un company de feina, JLRibas que era el Harold Berg fent una entrevista telefònica]. Extorsió o venjança amb imatges falses pornogràfiques, especialment a adolescents. (BBC) .

Hi ha Deepfakes a les xarxes socials, mostrant vídeos falsos de polítics (com un deepfake de Biden demanant no votar, 2024), fotos falses de celebritats, o atacs falsos. FB té un equip de moderació, Twitter/X ho ha edixat de fer després de l’adquisició d’Elon Musk, TikTok en té un de propi. Telegram no modera. En premsa tradicional, els mitjans sensacionalistes com “The Daily Wire” o “The Sun” han compartit imatges generades per AI sense verificar (ex.: fotos falses de la família reial britànica). A Youtube hi ha canals que fan servir AI per generar notícies falses amb veus sintètiques; intenten verificar. A fòrums de Reddit i 4chan https://www.4chan.org/ (on es poden penjar imatges anònimament) és on apareixen notícies falses amb suport AI que després es fan virals.

“The New York Times”, “BBC” (Reality Check: Analitza vídeos amb eines com InVID per detectar manipulacions), “Reuters” i “EFE” tenen unitats de fact-checking específiques (com “Reuters Fact Check”). A Espanya, “Maldita.es”, “Newtral” i “Verificat” (de Catalunya Ràdio) analitzen deepfakes. Associated Press (AP): Usa eines com Reverse Image Search i col·labora amb “FactCheck.org”. Facebook (Meta): Inclou metadades a les imatges generades amb IA (segons acords amb Adobe). Hi ha eines com Intel’s FakeCatcher (detecta alteracions en el pols en vídeos), Sensity AI o Deepware Scanner. A les imatges es poden detectar errors en ombres o textures.

Risc de disrupció

La incorporació de la AI en la presa de decisions quan encara no l’acabem d’entendre, la possibilitat de falsificar la realitat, demanaria precaució i regulació. Avisos de Steve Wozniak i Elon Musk (The Verge). Legislació Europea sobre riscos de la AI (BBC). Carta sobre els riscos de la AI (wikipedia). Una AI al control d’infraestructures amb la directivar de preservar el planeta podria decidir eliminar l’espècie humana (New Yorker). Riscos de biaix a l’hora de d’assignar nivells risc de crèdit (The Verge). Among the Ai doomsayers (New Yorker). [Si cedim el control d’infrastructures a la AI i, segons la programació, aquesta arriba a pensar que la humanitat suposa una amenaça, podria decidir eliminar-nos. “In 2016, while training one of their models to play a boat-racing video game, OpenAI researchers instructed it to get as many points as possible, which they assumed would involve it finishing the race. Instead, they noted, the model “finds an isolated lagoon where it can turn in a large circle,” allowing it to rack up a high score “despite repeatedly catching on fire, crashing into other boats, and going the wrong way on the track.” Maximizing points, it turned out, was a “misspecified reward function.” Now imagine a world in which more powerful A.I.s pilot actual boats—and cars, and military drones—or where a quant trader can instruct a proprietary A.I. to come up with some creative ways to increase the value of her stock portfolio. Maybe the A.I. will infer that the best way to juice the market is to disable the Eastern Seaboard’s power grid, or to goad North Korea into a world war. ” …”Of the three people who are often called the godfathers of A.I.—Geoffrey Hinton, Yoshua Bengio, and Yann LeCun, who shared the 2018 Turing Award—the first two have recently become evangelical decelerationists, convinced that we are on track to build superintelligent machines before we figure out how to make sure that they’re aligned with our interests. [no sabem si les instruccions que els donem faran realment el que esperem, com a Caixa es va requerir al Helpdesk que les trucades havien de ser de < 3 min i el resultat és que penjaven i el client havia de tornar a trucar. El film Wargames de 1983 ja mostrava un escenari similar]. Ted Chiang assenyala que la AI és només un resum del publicat , com un JPEG, i que per tant l’especulació sobre si farà un salt qualitatiu d’intel·ligència, millorant-se exponencialment (i amenaçant la raça human) no està justificada. (New Yorker).

Riscos de l’acompanyament

La dificultat de les relacions humanes fa que la companyia d’un xatbot humanoide pugui ser més agradable (BBC ). És el que il·lustrava el film Her (2013). Es pot arribar a casos d’addicció (Vox), i hi ha documentat el suïcidi d’un noi després d’una relació amb Character ai ( Spiegel). Com que les aplicacions són de pagament es planteja el debat de si estaran programades per al benestar del client o per que gasti més diners (The Verge). Google ha redactat un document de treball de 300 pàgines, L’ètica dels assistents AI avançats, que s’ha d’interrogar sobre què vol dir la vida bona, agrable? realitzada?

D’altra banda hi ha evidències d’errors (Fastcompany, BBC). Empreses que senten que per vendre han d’incorporar com sigui AI, encara que no tingui gaire sentit. Coixins, raspalls de dents, aspiradores al CES de les Vegas (BBC). S’està invertint molt en AI però no arriben els beneficis econòmics esperats. Axios. Els científics no acaben d’entendre com funciona la AI (Vice).

Però al mateix temps, està obrint noves maneres de fer ciència, generant models (Quanta). Investigadors han pogut reduir de 32M possibilitats a 18 els compostos inorgànics interessants. ( BBC ). La AI pot explorar milions de compostos i proposar els candidats a antibiòtics amb més possibilitats com l’Halicin i l’abaucina (Cell, Nature). Més antibiòtics (BBC)

Necessitat i alhora dificultat d’incorporar moral

[La AI que guia Un taxi sense conductor s’ha d’enfrontar amb quelcom, semblant al Trolley Problem, per exemple si hi ha risc d’atropellar, o bé una home gran, o bé un nen]. Els models han intentat ser ajustats manualment per evitar respostes que puguin induir al suïcidi, o que permetin fer atemptats].

Google Gemini, l’equivalent a chatGPT, vol ser tan políticament correcte que acaba sense moral i essent incapaç de condemnar res. (BBC ). [Potser no podem pretendre que la AI sigui capaç de respondre qüestions ètiques si els humans tampoc ens hi hem posat d’acord, trobo injusta la crítica d’aquest professor (The Verge).

2025 Vogue publica un anunci de Guess amb una model generada per AI. [abans es publicaven gravats i il·lustracions, oi?] (BBC)

La història humana, amb els avenços en energia, mobilitat, llibres, calculadores, GPS, es pot veure com una continuació de l’evolució on cada vegada necessitem saber fer menys coses. Bill comenta que amb la AI, els humans ja no seran necessaris per la majoria de les tasques (CNBC). Acabarem en una bici estàtica fent sudokus? Ens trobem en una situació similar a la dels indígenes amb desestructuració cultural. Ja no han de caçar perquè troben la carn al supermercat. Ja no cal buscar les fonts d’informació ni pensar críticament perquè ja trobem la resposta al “supermercat” de la AI.

A Sàpiens Yuval Harari assenyalava que a nivell individual l’individu del paelolític tenia molts més recursos per sobreviure que no pas l’home modern [jo feia d’auditor però no sé conrear, ni caçar, ni construir un refugi, ni teixir, coure ceràmica] que depèn d’una complexa xarxa de divisió del treball.

Consciència en màquines

Ja tenim sistemes que semblen intel·ligents, encara que poguem discutir si entenen o no. Podem plantejar si algun dia tindran emocions), o si en algun moment donat ja tenen consciència.

Igual que al s19 es va deixar de buscar la “xispa de la vida” [que animaria de cop un munt de matèria] per mirar d’identificar les parts i processos dels sistemes vius, ara s’està fent el mateix amb la consciència [fins a quin punt ha d’estar vinculada a l’orgànic com en els animals, o requereix el llenguatge?]. Així s’intenta trobar una correlació entre experiències conscients i activitat neuronal. Kyle Fish d’Anthropic, arriben a suggerir que és possible que alguns chatbots ja siguin conscients (Taking Ai welfare seriously ). Una de les raons seria que enr ealitat ni tan sols els desenvolupadors saben ben bé què passa dins dels LLM. D’altres estan desenvolupant pels LLM interfases de vídeo i audio [jo vaig suggerir LLM per a contingut oral] i així potser replicaríem el que està passant als nostres cervells. Una altra àrea de recerca consisteix a preparar “mini-brains” agrupacions d’unes poques neurones en una placa. Algun d’aquests és capaç de jugar a pong (1972). (BBC)

Un museu de la AI

“Pensar amb màquines: una història de la Intel·ligència Artificial”

- Els orígens (1950-1970): simulant la conversa i el pensament

Test de Turing: una màquina és intel·ligent si quan interactuem amb ella no es pot distingir d’un humà.

ELIZA (1966): programa que programa simula una psicoterapeuta rogeriana. Esquema del codi. - IA simbòlica i raonament lògic (1970-1985)

Declarant fets i regles podem extreure conclusions. O a partir d’una conclusió com un símptoma mèdic, podem inferir quins fets el podrien desencadenar, és a dir, fer-ne un diagnòstic. Gràfic de regles IF-THEN. Lisp (TIO), Prolog (SWISH, Learn prolog).

Simulació diagnòstic mèdic MYCIN (Symptomate). Crear un arbre genealògic en PROLOG i fer preguntes (“Qui és l’avi de…”).

Tenim el coneixement i fem servir el programa per extreure’n conclusions. Deducció. - IA i jocs: pensament estratègic